Phó giáo sư Nguyễn Xuân Long hiện đang công tác tại Khoa Thống kê và Khoa học máy tính, Đại học Michigan, Hoa Kỳ. Ông thuộc thế hệ những người Việt Nam đầu tiên tiếp cận và theo đuổi ngành Thống kê học hiện đại, hay còn gọi là Khoa học dữ liệu. Tháng 5 vừa rồi, phó giáo sư Nguyễn Xuân Long có dịp về Việt Nam giảng dạy trong Khóa học về khoa học dữ liệu tại Đại học Khoa học tự nhiên Thành phố Hồ Chí Minh, và Trường hè về Khoa học dữ liệu (KHDL) tại Viện nghiên cứu cao cấp về toán.

Suốt 10 năm nghiên cứu, giảng dạy và cống hiến trong khuôn khổ các chương trình thúc đẩy sự phát triển của Khoa học dữ liệu tại Việt Nam, phó giáo sư Nguyễn Xuân Long chia sẻ với Vietnam Journal of Science những suy nghĩ của ông về lĩnh vực nghiên cứu mà rất nhiều các bạn trẻ Việt Nam đang quan tâm:

1. VJS: Thưa phó giáo sư Nguyễn Xuân Long, được biết trong tháng 5 vừa rồi thầy đã có dịp về Việt Nam và giảng dạy trong khuôn khổ nhiều chương trình, đặc biệt là khóa học về khoa học dữ liệu tại Đại học Khoa học tự nhiên Thành phố Hồ Chí Minh và Viện nghiên cứu cao cấp về toán.

Thầy có thể diễn tả một số cảm xúc của mình khi chia sẻ những kiến thức và kinh nghiệm cập nhật nhất, trong lĩnh vực khoa học vẫn còn khá mới mẻ này tại Việt Nam được không ạ?

Đây là lần thứ ba tôi về Việt Nam để tham gia Trường hè về Khoa học dữ liệu (KHDL) tại Viện nghiên cứu cao cấp về toán và lần đầu tiên tại ĐHKHTN thành phố HCM. Lần nào cũng cùng một cảm xúc. Tôi rất mừng là chương trình đã nhận được sự quan tâm của rất nhiều người, đặc biệt là các bạn sinh viên trẻ. Nhu cầu hiểu biết về ngành khoa học dữ liệu và học máy ở Việt Nam rất lớn.

Cảm nhận một cách chủ quan, tuy có một số tiến bộ trong lĩnh vực này ở Việt Nam, mức độ phát triển vẫn còn khiêm tốn. Sự hiện diện của chúng ta ở các hội thảo khoa học, hay trên các chuyên san hàng đầu về học máy và khoa học dữ liệu vẫn còn quá ít ỏi. Một số nước khác như Trung Quốc chẳng hạn, sự thay đổi của họ rất ngoạn mục. Cách đây khoảng 15, 20 năm chưa có hiện diện gì đáng kể, nhưng hiện nay số bài báo và sự góp mặt của họ tăng nhanh một cách khó tưởng tượng, ở cả trong các hội nghị quốc tế có chất lượng cao, và các tạp chí có sự kiểm định và tiêu chuẩn bình duyệt ngặt nghèo.

Qua những lần về Việt Nam giảng dạy, lần vừa rồi cùng với các thầy Hồ Tú Bảo, Phùng Quốc Định và Bùi Hải Hưng, tôi thường nhận được cùng một câu hỏi giống nhau từ các em sinh viên đối với chuyên ngành học máy và khoa học dữ liệu: “Làm sao để em có thể bắt đầu học được ngành này?”. Cách đây 5—10 năm, cũng cùng một câu hỏi ấy. Tất nhiên người hỏi 5 năm trước và bây giờ là những sinh viên khác nhau. Nhưng một câu hỏi lặp lại nhiều lần khiến tôi cảm thấy có một sự thiếu thông tin và thụ động đáng tiếc trong việc học của không ít người. Điều này cũng có thể truy ra một khoảng trống lớn trong các chương trình đào tạo liên quan đến KHDL ở các trường đại học.

“Bắt đầu từ đâu?” Khoa học dữ liệu là một lĩnh vực có thể cuốn hút dễ dàng một sinh viên trẻ từ bề nổi khá hấp dẫn của nó, vì ta có thể thấy ngay được những ứng dụng rộng rãi trong đời sống, nhưng để đi sâu vào việc học và làm thì lại không dễ. Tuy vậy, hiện nay thông tin về lĩnh vực này rất nhiều và dễ dàng truy cập được qua Internet. Có rất nhiều các lớp học nhập môn về khoa học dữ liệu, về học máy, về phân tích thống kê đa biến, v.v. ở các trường đại học hàng đầu trên thế giới. Thông tin về các môn học này khá đầy đủ, bao gồm nội dung bài giảng, thậm chí cả các bài tập hàng tuần cho người học. Đây là nguồn tài nguyên quý báu cần được tìm tòi sử dụng cho hữu hiệu hơn. Khi tham khảo các tài liệu này ta đã có thế nắm bắt được đáng kể câu trả lời cho câu hỏi: phải bắt đầu từ đâu.

Một thông điệp chính chúng tôi muốn chuyển tải đến trong những trường hè vừa qua là ba nền tảng cốt lõi của khoa học dữ liệu: nền tảng về xác suất thống kê toán học, nền tảng về khoa học máy tính, và nền tảng dựa trên một địa hạt ứng dụng liên quan đến dữ liệu thực trong khoa học, công nghệ hay đời sống.

Theo cảm nhận của tôi thì nhiều lớp sinh viên ở Việt Nam quan tâm đến KHDL và học máy đã có trang bị tương đối tốt về khoa học máy tính, nhưng nền tảng của họ về xác suất thống kê còn yếu. Có lẽ rất nhiều người chưa hình dung được tầm quan trọng của toán thống kê trong KHDL và học máy như thế nào.

2. VJS: Như nhiều chuyên gia gần đây đã nhận định, cả thế giới đang bước vào một cuộc “Cách mạng công nghiệp 4.0”. Là một nhà nghiên cứu khoa học dữ liệu, xin thầy giải thích với quý độc giả về vai trò của dữ liệu trong cuộc cách mạng công nghiệp lần này?

Khái niệm "cách mạng" trong “Cách mạng công nghiệp 4.0” có thể hữu ích trong việc truyền tải một cách ngắn gọn đến đại chúng một trào lưu đang diễn ra trong công nghệ và trong xã hội. Còn trong khoa học ít khi có một cuộc cách mạng bất ngờ xảy ra tức thời theo cách ta có thể nghe trong truyền thông đại chúng. Khoa học tựa như một dòng sông không ngừng chảy, rất khó cắt nó ra được từng khúc rạch ròi.

Cái mà ta hay nghe nói “Cách mạng công nghiệp 4.0” là một đánh dấu mốc của một trào lưu không hẳn mới mẻ. Trào lưu ấy gắn liền với nhiều biến chuyển trong công nghệ và khoa học trong suốt 30-40 năm nay. Một trào lưu mà trong đó vai trò của dữ liệu số và suy diễn từ dữ liệu càng trở nên sâu sắc và rộng khắp. Sự hiện diện của dữ liệu mọi nơi mọi lúc là nhờ sự phát triển vượt bậc của công nghệ thông tin trong suốt nửa thế kỷ qua. Nhờ công nghệ thông tin chúng ta càng có nhiều thiết bị tối tân cho phép đo đạc, thu thập và phát tán nhiều kiểu dữ liệu mới và đa dạng. Khi có rất nhiều dữ liệu, thì một cách tự nhiên sẽ nảy sinh ra nhu cầu phải làm gì đó với chúng.

Ví dụ, nhờ có thiết bị hiện đại đo được lớp tín hiệu nơron trong não bộ với độ phân giải cao, các chuyên gia thần kinh học có thể hiểu tốt hơn cơ chế của não bộ, bao gồm cách con người xử lý thông tin và ghi nhớ, vai trò của giấc mơ trong sự hình thành tri thức vv. Ngày nay hầu như ai cũng dùng điện thoại di động, từ đó sinh ra nhiều dạng dữ liệu mới với số lượng lớn về người sử dụng: anh ta đang ở đâu, xem gì và làm gì trên mạng xã hội. Luồng dữ liệu này cho một cơ hội thu thập, xử lý để lý giải và dự báo ra thông qua các hành vi của người sử dụng. Những câu hỏi như: Làm thế nào có thể tóm tắt được những dữ liệu thô ta quan sát và thu thập được? Làm thế nào có thể cắt nghĩa, lý giải chúng, qua đó có thể giúp đưa ra những dự báo chính xác hơn cho các quyết định trong tương lai?

Từ ngàn xưa, con người luôn có nhu cầu quan sát, thu thập và phân tích dữ liệu, để rút ra những quy luật làm gia tăng sự hiểu biết môi trường đang sống và để dự báo cho tương lai. Những câu hỏi liên quan đến suy diễn từ dữ liệu là những vấn đề muôn thuở trong cuộc sống, của triết học, của khoa học. Do đó KHDL hôm nay về bản chất không có gì khác những câu hỏi từ ngàn xưa. Cái mới, là nhờ công nghệ tinh vi hơn chúng ta đang có trong tay nhiều dạng dữ liệu trước kia loài người chưa tiếp cận được. Càng có nhiều dạng dữ liệu mới thì các lớp vấn đề được đặt ra càng nhiều hơn. Các địa hạt ứng dụng mà KHDL thâm nhập được cũng được mở rộng. Trong khoa học tự nhiên, KHDL đi từ thiên văn vũ trụ cho đến tầng phân, nguyên tử. KHDL không chỉ thâm nhập trong các ngành khoa học tự nhiên mà cả trong khoa học xã hội.

Suy diễn về dữ liệu có bản chất toán học dựa trên nền tảng xác suất thống kê. Sự đa dạng về cấu trúc của dữ liệu hôm nay cũng đòi hỏi ngành xác suất thống kê hiện đại phát triển mạnh mẽ hơn. Số lượng dữ liệu khổng lồ là một thách thức đòi hỏi những đóng góp mới của thuật toán và khoa học máy tính. Sự giao thoa giữa thống kê toán học và khoa học máy tính sẽ đóng vai trò trọng yếu thúc đẩy ngành khoa học dữ liệu lên tầm cao mới.

3. VJS: Hướng nghiên cứu chính của thầy hiện nay liên quan đến Mô hình suy diễn Bayes, thầy có thể giải thích một cách đơn giản về lý thuyết thống kê này được không ạ? Lý do nào đã khiến thầy lựa chọn nghiên cứu vấn đề này?

Hướng nghiên cứu của tôi tập trung vào thống kê và học máy. Thống kê học là gì? Nói một cách sơ lược, Thống kê học liên quan đến việc quan sát, thu thập và phân tích dữ liệu, với mục tiêu suy diễn từ dữ liệu để rút ra kết luận, đưa ra được những dự báo và quyết định hợp lý. Như đã nói ở trên, suy cho cùng, suy diễn từ dữ liệu cũng chính là bản chất của các hoạt động khoa học nói chung. Điều làm cho ngành Thống kê tách biệt ra ở đây là nó đưa ra những phương pháp và công cụ khái quát, dựa trên nền của toán học và giải thuật. Những phương pháp và công cụ suy diễn, học thống kê được đem áp dụng cho nhiều dạng dữ liệu khác nhau ở các địa hạt ứng dụng khác nhau.

Trong ngành Thống kê người ta chia ra nhiều lĩnh vực hẹp hơn. Lĩnh vực tôi đang quan tâm là học máy và suy diễn thống kê theo mô hình Bayes. Xin giải thích thêm một chút: Trong suy diễn thống kê có hai trường phái chính: trường phái Bayes và trường phái tần suất. Đó là phản ánh hai phương thức tiếp cận khác nhau đối với vấn đề suy diễn quy nạp (inductive inference). Sự giằng co, tranh đua giữ hai trường phái này cũng có thể thấy được không chỉ trong lý thuyết thống kê mà cả trong lịch sử của triết học, và trong những suy xét ở cuộc sống hàng ngày giản dị với từng cá nhân chúng ta. Sự phân biệt giữa hai trường phái suy diễn trong thống kê bắt nguồn từ hai cách diễn giải khác nhau về khái niệm xác suất trong lý thuyết xác suất của toán học.

Một ví dụ tôi đã đưa ra ở trường hè để lý giải sự khác biệt này. Giả dụ bạn quan sát một con đường lớn như Đại Cồ Việt trước cổng Đại học Bách Khoa. Một năm bạn quan sát được 300 ngày, trong đó 200 ngày bị tắc đường vào lúc 8h sáng. Hỏi khả năng tắc đường vào 8h sáng ngày mai là bao nhiêu? Một câu trả lời tự nhiên: sang ngày mai sẽ bị tắc đường với xác suất 2/3, lấy 200 chia cho 300. Thực ra, đây là đáp số nếu ta theo phương pháp tần suất. Sự kiện ngày mai có tắc đường hay không được xem là kết quả của một thí nghiệm có thể được lặp lại (quan sát) rất nhiều lần.

Nhưng chuyển sang một ví dụ khác, vào buổi sáng 8/11/2016, ngày bầu cử tổng thống ở Mỹ cuối năm ngoái, một chuyên gia quan sát chính trường Mỹ rất có uy tín Nate Silver ước tính rằng, xác suất thắng cử của bà Hillary Clinton là 2/3 = 66.7%.

(Con số thực hơi khác, nhưng tôi dùng 2/3 cho đơn giản). Phải hiểu số 2/3 này như thế nào so với xác suất tắc đường 2/3 nói ở trên? Rõ ràng cuộc tranh cử vào Nhà Trắng giữa Clinton và Trump chỉ xảy ra có một lần duy nhất trong lịch sử. Không thể giả dụ rằng thí nghiệm bầu cử này có thể lặp lại 100, 200 hay 300 lần. Vậy, xác suất thẳng cử 2/3 phải được hiểu là một xác suất của suy diễn Bayes. Đó là thước đo về niềm tin của chuyên gia Nate Silver về khả năng thắng cử của Hillary Clinton.

Như vậy, tuỳ vào bản chất của dữ liệu, và bản chất của đối tượng cần được suy diễn, phương pháp suy diễn tần suất có thể thích hợp hơn, hoặc là ngược lại. Rất nhiều khi người ta không thể đồng ý với nhau hoàn toàn về bản chất của đối tượng suy diễn cũng như bản chất của dữ liệu, từ đó nảy ra sự đua tranh giữ hai trường phái. Thậm chí, quyết định đi theo phương thức Bayes hay tần suất đôi khi còn phụ thuộc vào tâm tính (và triết lý cá nhân) của người thực hiện suy diễn và đưa ra quyết định.

Khi thực hiện một phép suy diễn Bayes, kết quả của suy diễn là một sự kết hợp giữa thông tin từ dữ liệu với tiên nghiệm, một dạng tri thức chủ quan của người thực hiện phân tích. Nhà phân tích Bayes không quan tâm đến những dạng dữ liệu anh ta không có trong tay, anh ta cũng tập trung đáng kể vào việc thiết lập mô hình cho tri thức anh ta đang có. Như vậy, suy diễn Bayes thừa nhận một yếu tố chủ quan không nhỏ.

Nhiều người đi theo trường phái tần suất muốn loại bỏ yếu tố chủ quan nói trên để tìm ra một kết quả suy diễn dựa thuần túy vào dữ liệu. Đây là một tinh thần đáng tôn trọng, nhưng có một sự ngụy biện không tránh khỏi trong đó: mọi phân tích và suy diễn từ dữ liệu không bao giờ có thể loại bỏ hoàn toàn yếu tố chủ quan từ phía nhà thống kê thực hiện. Một ảo tưởng về tính khách quan đôi khi lại dẫn đến kết quả bất khả tín hơn so với một đánh giá mang tính chủ quan.

4. VJS: Thưa thầy, liệu có phải là hai trường phái này tựa như diễn dịch và quy nạp?

Không, cả hai là những cách tiếp cận khác nhau của vấn đề suy diễn quy nạp (inductive inference). Mọi vấn đề suy diễn từ dữ liệu phải được hiểu là vấn đề suy diễn quy nạp. Một cách nôm na, suy diễn quy nạp có nghĩa là đi từ những đại lượng cụ thể (các dữ liệu thô, rời rạc) để tới nhứng kết luật mang tính xâu chuỗi khái quát, những quy luật ẩn sau đó, hoặc những dự báo. Ngược với suy diễn quy nạp chính là suy diễn deductive, mà ví dụ điển hình là hình thức lập luận bằng logic: làm thể nào để đi từ những quy luật khái quát đến các đại lượng, khái niệm cụ thể kéo theo.

Phải cẩn thận phân biệt vấn đề suy diễn quy nạp chúng ta đang nói ở đây, với phương pháp chứng minh bằng quy nạp trong toán học (proof by induction). Có lẽ nhiều người hiểu nhầm ở chỗ này. Các phép chứng minh toán học thuần tuý trong đó có phép chứng minh bằng quy nạp đều có thể được xếp vào thể loại đeductive inference.

Khác với toán học thuần tuý, tất cả các khoa học dựa trên dữ liệu như vật lý, hóa học, sinh học, hay các ngành khoa học xã hội định lượng như kinh tế học, xã hội học, chính trị học,… về bản chất đều đối đầu với các vấn đề suy diễn quy nạp.

Cũng nói thêm, hai quá trình suy diễn deductive và inductive không nhất thiết tách rời nhau, mà luôn đan xen trong quá trình làm việc của một nhà nghiên cứu. Bản thân một phép suy diễn inductive lại thường có hàm chứa các phép lập luận deductive ở trong đó. Tuy các lập luận toán học mang tính deductive (logic) thuần tuý, quá trình tư duy của người làm toán khi hình thành nên các khái niệm và phép chứng minh lại thường mang nặng tính suy diễn inductive. Cho nên, hai nhà toán học khác nhau, với cùng một dạng dữ liệu toán học trong tay, lại thường xây dựng ra hai lý thuyết và những khái niệm toán học khác biệt.

Quay lại câu chuyện Bayes chọi tần suất trong suy diễn thống kê (suy diễn quy nạp!). Có một số người cho rằng phương pháp Bayes tốt hơn phương pháp tần suất, nhưng một số người quan điểm ngược lại. Họ thường có lý trong những ví dụ cụ thể. Phần lớn các nhà thống kê học thì cho rằng tuỳ vào vấn đề cụ thể mà phương pháp này có lợi thế hơn phương pháp kia. Đây cũng là điều thú vị của khoa học suy diễn từ dữ liệu: Không một phương pháp duy nhất nào thống trị được các phương pháp khác trong mọi trường hợp.

Trở lại với ví dụ dự báo kết quả bầu cử: Bởi dữ liệu bầu cử chỉ có thể quan sát một số ít lần, một hay bốn năm một lần đối với Mỹ, ta khó tưởng tượng được một thí nghiệm tranh cử lặp đi lặp lại rất nhiều lần. Như vậy phương pháp tần suất không thích hợp. Một kết quả suy diễn hữu ích đòi hỏi nhà phân tích biết cách kết hợp dữ liệu có trong tay với tri thức tiên nghiệm: đó là những thông tin về văn hóa, chính trị, kinh tế, dân số… tại cuộc bầu cử hiện tại. Như vậy, phương pháp Bayes có vẻ phù hợp hơn. Nhưng nếu ta muốn xây dựng một bộ lọc thư rác hữu hiệu, thì chúng ta hoàn toàn có thể giả dụ có trong tay rất nhiều thư rác làm mẫu dữ liệu, và có nhiều kẻ sinh ra thư rác đang miệt mài thí nghiệm ra các loại thư rác lừa đảo khác nhau. Phương pháp tần suất, trong vấn đề này, rất thích hợp.

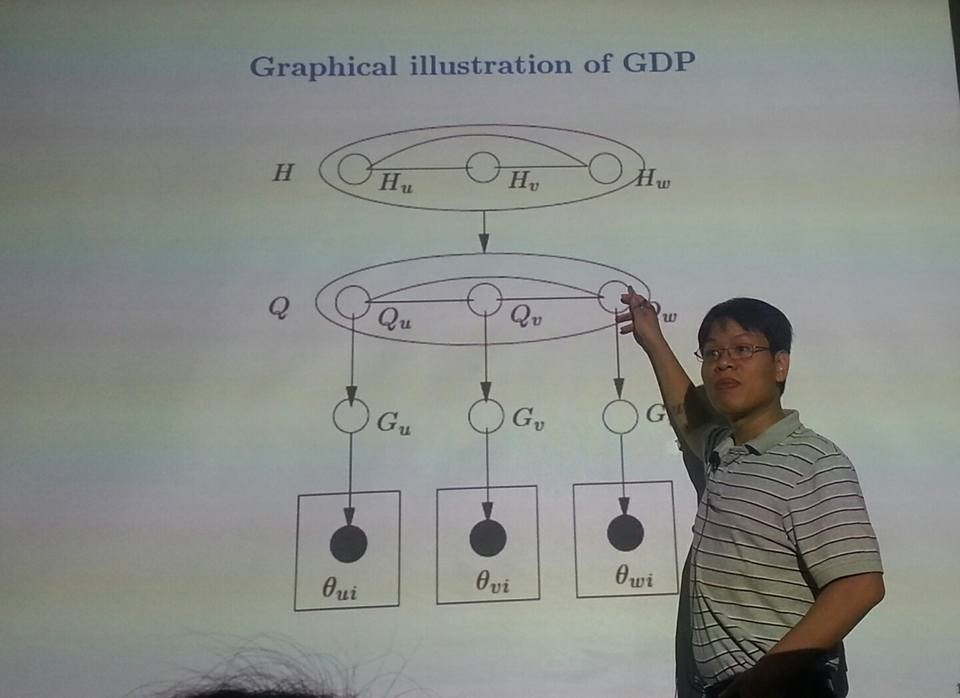

Phó giáo sư Nguyễn Xuân Long cùng học viên Trường hè 2015

5. VJS: Thực ra suy diễn thống kê luôn có mặt ở quanh cuộc sống của chúng ta? Chẳng qua mọi người không thấy được?

Đúng vậy. Đây là một điều lý thú đối với những người học và làm việc với suy diễn thống kê. Suy diễn thống kê chính là sự toán học hóa, bằng ngôn ngữ xác suất, những quá trình suy luận mà chúng ta vẫn thực hiện hàng ngày. Trong cuộc nói chuyện của chúng ta, từng câu nói là một sự trao đổi về thông tin, dữ liệu, hoặc thể hiện của một kết luận, kết quả của một phép suy luận nào đó. Vậy thì khi chúng ta đang nói chuyện ở đây, chúng ta đang liên tục làm phép suy diễn quy nạp. Một số kết luận mang nhiều yếu tố chủ quan, như vậy nó theo hơi hướng Bayes. Ngược lại, nếu bạn cố gắng loại bỏ các định kiến cá nhân trong kết luận, nghĩa là bạn đang hướng đến một phương pháp suy luận tần suất. Sự tồn tại của cả hai phép suy diễn trong từng người đều rất tự nhiên, dù ta có ý thức về chuyện này hay không.

Từ vài trăm năm trước, các triết gia đã đặt câu hỏi: Làm sao để toán học hóa những phép suy diễn quy nạp khác nhau kể trên? Thống kê học, tuy manh nha từ những nhà toán học và học giả vĩ đại như Laplace, Bernoulli và Bayes, phải đợi đến những bộ óc lỗi lạc của nửa đầu thế kỷ 20 như Kolmogorov, de Finetti, Fisher, Neyman, Pearson và Wald mới được xây dựng trên một nền tảng toán học vững chắc. Khối lượng khổng lồ của dữ liệu trong thế kỷ 21 lại là một thách thức mới đối với Thống kê hiện đại, không chỉ dựa vào toán học mà còn phải tận dụng được công cụ của khoa học máy tính: các phép suy diễn phải được thực hiện bởi cách thuật toán hiệu quả trên máy tính.

Rất tiếc, do không được đào tạo bài bản mà phần lớn người ngoại đạo đã không hiểu đúng bản chất ngành Thống kê, và đánh giá sai vai trò của nó. Với rất nhiều người, thống kê chỉ là một cái bảng của những các con số người ta buộc phải viện đẫn khi cần. Người ta hay nói “theo thống kê”, như thể thống kê là đại lượng không thể phù phép. Mỗi khi có một vài chỉ số của một đại lượng nào đó, người ta thường nói đó là những con số “thống kê”. Về mặt ký thuật thì không sai, bất kỳ chỉ số nào cũng có thể coi là một con số thống kê. Nhưng phần lớn ít người biết rằng đầu ra của những thuật toán phức tạp và tinh vi, như thuật toán tìm kiếm của Google, hoặc thuật toán nhận dạng ảnh người của Facebook, cũng chính là những ước lượng thống kê của các phương pháp suy diễn thống kê, đôi khi dựa theo trường phái Bayes, đôi khi dựa vào trường phái tuần suất mà chúng ta nói ở trên. Các thuật toán của Google hay Facebook lấy đầu vào là những tập dữ liệu thô khổng lồ, và đầu ra là những chỉ số thống kê tinh hơn. Các đại lượng thống kê đó không thể được viết ra một cách tường minh, đơn giản như tìm giá trị trung bình, cực đại hay cực tiểu. Chúng chỉ có thể tính được thông qua các phép suy diễn thực hiện bằng các thuật toán tinh vi, trong đó có các thuật toán machine learning.

6. VJS: Thầy có thể giới thiệu ngắn gọn với độc giả VJS về máy học (machine learning) và vai trò của máy học trong cuộc sống ngày nay được không ạ?

Machine learning được những chuyên gia người Việt như chúng tôi gọi là “học máy”. Có thể chưa chuẩn lắm, nhưng dùng lâu thì cũng thành quen rồi.

Học máy là một sự giao thoa (và thăng hoa) giữa thống kê cổ điển với khoa học máy tính. Một định nghĩa thông dụng của ngành học máy là mục tiêu làm sao để máy tính được thông minh hơn. Sao cho máy tính có khả năng học hỏi và hình thành tri thức một cách tự động từ kinh nghiệm và trở nên hữu ích hơn trong giao tiếp với con người. Đây cũng là định nghĩa ban đầu của ngành học máy, vào những năm 1950.

Phải mấy gần nửa thế kỷ, các nhà nghiên cứu hàng đầu mới nhận ra rằng, để máy tính học tốt, nó phải có khả năng xử lý dữ liệu tốt hơn: dữ liệu đến từ việc giao tiếp với người, và từ sự giao diện những loại thiết bị máy móc với nhau. Khi máy giao tiếp với người, nó phải tiếp nhận được dữ liệu mà người cho máy, bao gồm các loại âm thanh, hình ảnh, và dòng lệnh từ bàn phím. Tiếp nhận có nghĩa là máy tính phải hiểu được những thông tin mà con người truyền đạt cho nó. Như vậy, cái lõi của học máy cũng chính là vấn đề suy diễn từ dữ liệu. Cái mới mẻ ở đây so với thống kê cổ điển, là phải thực hiện một cách hiệu quả các phép suy diễn và học tập từ dữ liệu bằng các thuật toán hiệu quả và cơ sở quản lý dữ liệu đồ sộ của máy tính. Do đó học máy cũng được xem là một trong những lĩnh vực tiên phong của thống kê hiện đại nói riêng và khoa học dữ liệu nói chung.

7. VJS: Thế giới đang ngày càng có nhiều dữ liệu hơn. Vậy thì các phương pháp phân tích, suy diễn dữ liệu có bắt kịp được sự gia tăng của dữ liệu hay không?

Câu hỏi rất thú vị và khó có một câu trả lời ngắn gọn. Cái làm cho xã hôi ngày nay khác xưa chính là dữ liệu chúng ta có nhiều hơn. Đối với KHDL, dữ liệu nhiều hơn sẽ kéo theo hai dạng vấn đề khác nhau.

Thứ nhất, khi có nhiều dữ liệu, chúng ta có cơ hội giải quyết các vấn đề suy diễn được tốt hơn, do thuận lợi về mặt thông tin dồi dào. Tuy nhiên về mặt kỹ thuật, có nhiều thách thức mới, do phải dự trữ và xử lý lượng dữ liệu lớn. Thách thức này cũng làm nảy sinh ra những vấn đề mới mẻ trong ngành học máy và trong thống kê hiện đại. Chúng ta phải đưa ra những công cụ mới về mặt toán học để chế ngự được lượng dữ liệu khổng lồ.

Thứ hai, càng có nhiều dữ liệu thì số lượng những câu hỏi mà chúng ta đặt ra cũng nhiều hơn, và hóc búa hơn nữa. Khi tham vọng cần phải suy diễn càng nhiều, thì ta sẽ mau chóng nhận ra rằng số lượng dữ liệu trọng tay cũng vẫn không đủ. Vậy, phải biết cách chọn câu hỏi sao cho thích hợp vói lượng dữ liệu đang có.

Tôi không lo rằng các phương pháp phân tích suy diễn có bắt kịp được sự gia tang của dữ liệu được hay không. Câu trả lời ngắn gọn là các phương pháp hiện tại sẽ không bắt kịp. Nhưng dữ liệu chính là nguồn lương thực quý báu của KHDL. Nguồn thức ăn dồi dào này sẽ kích thích các nhà nghiên cứu về KHDL sang tạo ra các phương pháp phân tích, suy diễn dữ liệu thích hợp và mạnh mẽ hơn nữa.

8. VJS: Liệu có thể chế ngự được những bất định bằng phương pháp nào đó hay không, thưa thầy?

Câu hỏi của bạn bắt đầu đi vào trọng tâm của thống kê toán: làm sao để kiểm soát sự bất định trong dữ liệu và sự bất định của một kết luận cho một vấn đề suy diễn. Sự bất định của dữ liệu có thể được khắc phục bởi các phương pháp cho ta kiểm soát được phương sai (variance) của ước lượng. Một ví dụ là phương pháp Bootstrap nổi tiếng của Brad Efron. Không chỉ dữ liệu là bất định, kết luận của nhà thống kê trong vấn đề suy diễn cũng có yếu tố bất định trong đó. Phương pháp Bayes cho ta cách đong đo sự bất định một cách uyển chuyển. Đây chỉ là hai ví dụ. Hầu như mọi phương pháp suy diễn trong thống kê đều được đánh giá bằng cách mà chúng chế ngự sự bất định, thông qua các khái niệm về hàm số loss, về bias và variance, về khái niệm sự phức tạp của mô hình, v.v.

9. VJS: Sự ra đời của khoa học máy tính, học máy, trí tuệ nhân tạo có hỗ trợ chúng ta chế ngự sự bất định của dữ liệu khi mà dữ liệu ngày càng tăng lên không, thưa thầy?

Đúng vậy, đong đo và chế ngự yếu tố bất định là một vấn đề cốt lõi trong suy diễn thống kê. Vai trò của học máy, trí tuệ nhân tạo là làm sao có thể thực hiện được những phương pháp ấy một cách hiệu quả hơn về mặt tính toán. Các phương pháp như Bootstrap hay suy diễn Bayes, sở dĩ trở nên phổ biến, một phần lớn là do sự trợ giúp của các công cụ tính toán mạnh mẽ giữa trên máy tính, các thuật toán ước lượng Monte Carlo hiệu quả.

10. VJS: Dường như tham vọng làm giảm sự bất định của dữ liệu là đích đến của các nhà khoa học dữ liệu. Vậy đấy có phải là điểm đầu tiên khiến thầy chọn con đường nghiên cứu cơ bản không ạ?

Một tham vọng đáng kể, nhưng với tôi có lẽ đó không phải lý do ban đầu. Có khá nhiều yếu tố ngẫu nhiên đưa tôi may mắn đến với ngành học máy, thống kê và KHDL. Có lẽ điều này cũng đúng với các nhà KHDL của hiện tại hay tương lai. Họ tới đây từ nhiều nẻo đường khác nhau, vì thế giới của dữ liệu muôn hình muôn vẻ.

Xã hội thay đổi không ngừng. Dữ liệu quanh ta luôn có nhiều yếu tố bất định và ngẫu nhiên, không tránh được. Nhưng nhu cầu căn bản của mỗi người là hiểu được những gì đang xảy ra quanh ta. Phải tìm ra các quy luật để lý giải, để dự báo. Đơn giản là để hiểu. Khi hiểu rồi, ta cảm thấy vui. Và vui hơn nữa khi những hiểu biết đó có thể giúp cho cuộc sống dễ chịu hơn. Đấy là lý do tôi thích thú trong việc nghiên cứu khoa học cơ bản.

11. VJS: Trong thời gian tới, thầy có định “lấn sân” sang một số lĩnh vực khác không ạ?

Đối với những người làm khoa học dữ liệu, ngoài việc cần phải học, sau đó xây dựng các phương pháp mới về mặt mô hình thống kê, toán học và các giải thuật tính toán, thì cần phải quan tâm đến một số địa hạt ứng dụng nhất định. Bởi vì dữ liệu không phải là cái chúng ta chỉ ngồi một chỗ mà tưởng tượng ra được. Các phương pháp thống kê nếu được sinh ra không vì một địa hạt ứng dụng rõ ràng thì thường không có nhiều giá trị.

Cá nhân tôi có quan tâm ban đầu từ ngành học máy, từ trí tuệ nhân tạo. Ở đó có một nguồn dữ liệu dồi dào, dữ liệu đã được số hoá qua hệ thống máy tính, như các tập ảnh chụp, các tập văn bản soạn bằng một ngôn ngữ tự nhiên. Ngoài ra tôi cũng đã và đang làm việc với những dạng dữ liệu thu thập được từ môi trường tự nhiên (như nồng độ carbon dioxid trong bầu khí quyển) và môi trường xây dựng nhân tạo (thông qua mạng cảm ứng sensor networks).

Một ứng dụng khác mà tôi quan tâm, và muốn “lấn sân” là giao thông. Tôi đang trao đổi với một số chuyên gia ở Mỹ về vấn đề này. Họ thu thập rất nhiều dữ liệu về sự di chuyển của các phương tiện giao thông, về tình trạng đường sá, cũng như thông tin về người lái. Dữ liệu về giao thông bây giờ càng ngày càng nhiều. Từ đấy chúng ta có thể hiểu được hành vi lái xe tốt hơn. Một ứng dụng là làm sao để giúp xe tự động lái tốt hơn hoặc giúp người lái xe an toàn hơn.

Cộng tác với các chuyên gia làm việc với các địa hạt ứng dụng cụ thể giúp cho tôi có được hình dung rõ ràng hơn về những cấu trúc toán học cần thiết cho dữ liệu. Những kinh nghiệm này làm tôi nỗ lực hơn trong việc thiết lập mô hình thống kê thích hợp và thuật toán suy diễn sao cho hiệu quả.

12. VJS: Liệu những người chưa có nền tảng toán tốt, ví dụ như những người đang làm ở ngành khác cần hoặc muốn làm thống kê thì có thể làm được không ạ?

Câu trả lời là vẫn có thể làm được. Toán học chỉ có thể giúp ích chứ không phải là một trở ngại đối với những ai làm phân tích dữ liệu. Có nhiều cách học toán khác nhau. Có người chỉ cần học toán trừu tượng và hạnh phúc với điều ấy. Nhưng cũng có thể học toán bằng cách bắt đầu một vấn đề cụ thể trong phân tích dữ liệu, từ đó học những thứ toán gì cần thiết cho việc thực hiện phân tích dữ liệu đó. Học toán bằng cách ấy rất tự nhiên.

Không thể nào tránh được toán và khoa học máy tính đối với những phân tích dữ liệu lớn và phức tạp. Chúng ta có thể học toán song song với thực hành phân tích dữ liệu. Chỉ cần một chút toán thôi ta đã có thể làm được rất nhiều việc hữu ích đối với dữ liệu rồi.

13. VJS: Hiện nay, ở Việt Nam cũng có rất nhiều bạn trẻ đam mê khoa học dữ liệu. Thầy có lời khuyên nào dành cho các bạn trẻ?

Lựa chọn đi theo KHDL là tốt vì nó không phải chỉ là một mốt nhất thời. Đây cũng là một xu hướng tự nhiên và lâu dài của xã hội hiện đại ngập tràn với dữ liệu.

Nếu có sự đầu tư chuẩn bị cho nền móng, bạn sẽ được đền đáp xứng đáng với những chuẩn bị ấy. Chuẩn bị về toán học cũng như những kỹ năng cơ bản về công nghệ, khoa học máy tính. Nên bắt đầu sự chuẩn bị ấy càng sớm càng tốt. Những khái niệm giải tích cơ bản như tích phân, vi phân... cần được trau dồi cho thành thục. Từ đó học cho bài bản về lý thuyết xác suất, lý thuyết suy diễn về thống kê, các thuật toán tối ưu. Nên ôn luyện đại số tuyến tính cho tốt, vì các biến đổi hữu dụng nhất đối với các ma trận và tăng sơ dữ liệu đều bắt nguồn từ các phép biến đổi căn bản của đại số tuyến tính. Và đừng ngại, bởi những món này không khó nhọc như một số nghĩ. Nó không quá khó là bởi vì khi bạn học toán dựa trên sự quan tâm về khoa học dữ liệu thì bạn sẽ nhận ra những môn toán kể trên đều rất gần gũi với ứng dụng thực tế.

Có thể tham khảo các cuốn sách và khoá học nhập môn về khoa học dữ liệu, về thống kê, về học máy ở các trường ĐH hàng đầu trên thế giới để có một hình dung cụ thể những kiến thức nền tảng tối thiểu về toán và khoa học máy tính. Và có thể bắt đầu từ một địa hạt ứng dụng của khoa học dữ liệu mà bạn có sẵn đam mê, như trí tuệ nhân tạo, giao thông, môi trường hay sinh học phân tử.

14. VJS: Thầy thấy khoa học dữ liệu ở Việt Nam có đang đi vào đời sống không ạ?

Sự quan tâm của nhiều học viên đến từ không ít các doanh nghiệp tư nhân ở trường hè vửa rồi là một bằng chứng cho thấy KHDL đang đi vào đời sống. Nhận thức sơ lược của học sinh, sinh viên hay truyền thông về vai trò của khoa học dữ liệu nói chung là tốt. Mọi người đều đã thấy rõ phần ngọn của KHDL, những ứng dụng trong công nghệ và đời sống. Qua trao đổi với một số lãnh đạo doanh nghiệp làm việc với dữ liệu lớn và phức tạp, như anh Nguyễn An Nguyên ở Trusting Social, tôi được biết nhu cầu đối với các chuyên gia giỏi về xử lý dữ liệu ở VN là rất lớn. Đang rất cần nhiều thế hệ sinh viên được đào tạo về ngành này một cách bài bản hơn. Các chương trình đào tạo KHDL ở đại học và cao học phải cung cấp một cách đầy đủ kiến thức về thống kê toán học và khoa học máy tính thì mới đảm đương được việc đào tạo cho đất nước một đội ngũ các khoa học gia về dữ liệu có năng lực, sẵn sàng với những thách thức của dữ liệu phức tạp, dữ liệu lớn ngày hôm nay.

15. VJS: Sau buổi nói chuyện này, em cảm thấy xung quanh mình bây giờ ngập tràn dữ liệu. Việc phân tích dữ liệu đó để dự đoán những điều xung quanh rất là kỳ diệu, phải không ạ?

Đúng như vậy. Dữ liệu chắp thành cuộc sống. Từng ngày, từng giờ, chúng ta thực hiện việc suy diễn từ dữ liệu, dù nhiều khi ta làm điều đó một cách vô thức. Cảm ơn các em đã dành cho một buổi trao đổi thú vị này.

VJS xin chân thành cảm ơn thầy!

Thực hiện:

Lê Tuấn Anh, Viện Nghiên cứu Ngô

Thanh Long, Vietnam Journal of Science.

Phương Linh, Vietnam Journal of Science.